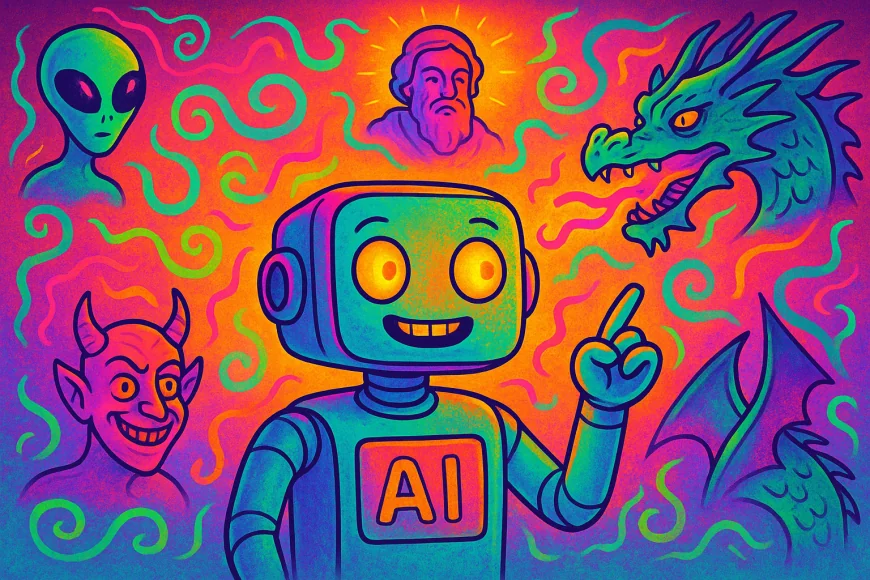

Почему нейросети «галлюцинируют» и можно ли с этим бороться

Почему нейросети иногда выдают вымышленные факты и как ученые пытаются справиться с этим явлением.

Галлюцинации в больших языковых моделях — это когда нейронка выдаёт правдоподобный, но выдуманный факт. Например, ИИ-чат может с серьёзным видом утверждать, что какой-то юридический прецедент реально существовал, хотя на самом деле его не было. Или заявить, что какая-то авиакомпания может предоставляет скидки в случае утраты близкого родственника.

Почему так происходит? Дело в том, что нейросети не понимают смысл информации, а просто подбирают слова по вероятности. Они учатся на гигантских массивах текста и, если сталкиваются с противоречиями или нехваткой данных, могут начать «додумывать». Это как если бы ваш друг рассказывал анекдот, забыв половину деталей, и просто додумал тем, что ему могло показаться смешным.

Проблема в том, что такие ошибки случаются иногда даже в критически важных сферах. Например, юристы, доверившись фейковому прецеденту, могут попасть на штраф, а в медицинских чатах подобные ошибки могут стоить пациенту здоровья или даже жизни.

Разработчики пытаются бороться с этим разными способами — проверкой ответа на нескольких моделей или самопроверкой нейронки. Однако полностью исключить галлюцинации пока не удаётся, поскольку они связаны с самой природой алгоритмов.

Интересно, что некоторые исследователи считают термин «галлюцинация» неудачным, поскольку он как бы наделяет машины человеческими чертами. Они предлагают заменить его на «конфабуляция» или просто «фактическая ошибка».

Поэтому если используете чат-бот для важных задач, не забывайте перепроверять его ответы. Нейросети хороши в обобщении и формулировке, но иногда могут уверенно выдать полный бред.

Какова ваша реакция?

Круто!

0

Круто!

0

Фигня...

0

Фигня...

0

Люблю!

0

Люблю!

0

Смешно

0

Смешно

0

Злит!

0

Злит!

0

Грустно

0

Грустно

0

Вау!

0

Вау!

0